mac의 Obsidian에서 사용하기 위해서 설치해 보았다.

LM Studio설정도 있지만 Ollama를 사용하는 것을 우선...

1. 사전 준비 사항

- homebrew를 사용하여 ollama를 설치

- ollma의 model을 다운로드

- Obsidian을 설치

2. Ollama 설치

2.1. Ollama의 Model 선택

ollama를 실행하여 로컬에 원하는 모델이 없는 경우 다운로드 한다

# 로컬의 모델 목록 조회

$ ollama list

# 원하는 모델 다운로드

$ ollama pull llama2 # llama3

2.2. Ollama 서버로 기동

ollama 서버를 기동은 brew에서 서비스에 등록하는 방법과

쉘에서 직접 실행하는 방법 중 원하는 것으로 한다.

# Local Cpilot Setup Guide 에 따른 서버 실행 (CORS 활성화 옵션 추가 된 Command)

$ OLLAMA_ORIGINS="app://obsidian.md*" ollama serve

# brew로 서비스 등록의 서버 실행

$ brew services start ollama

3. Obsidian 설치

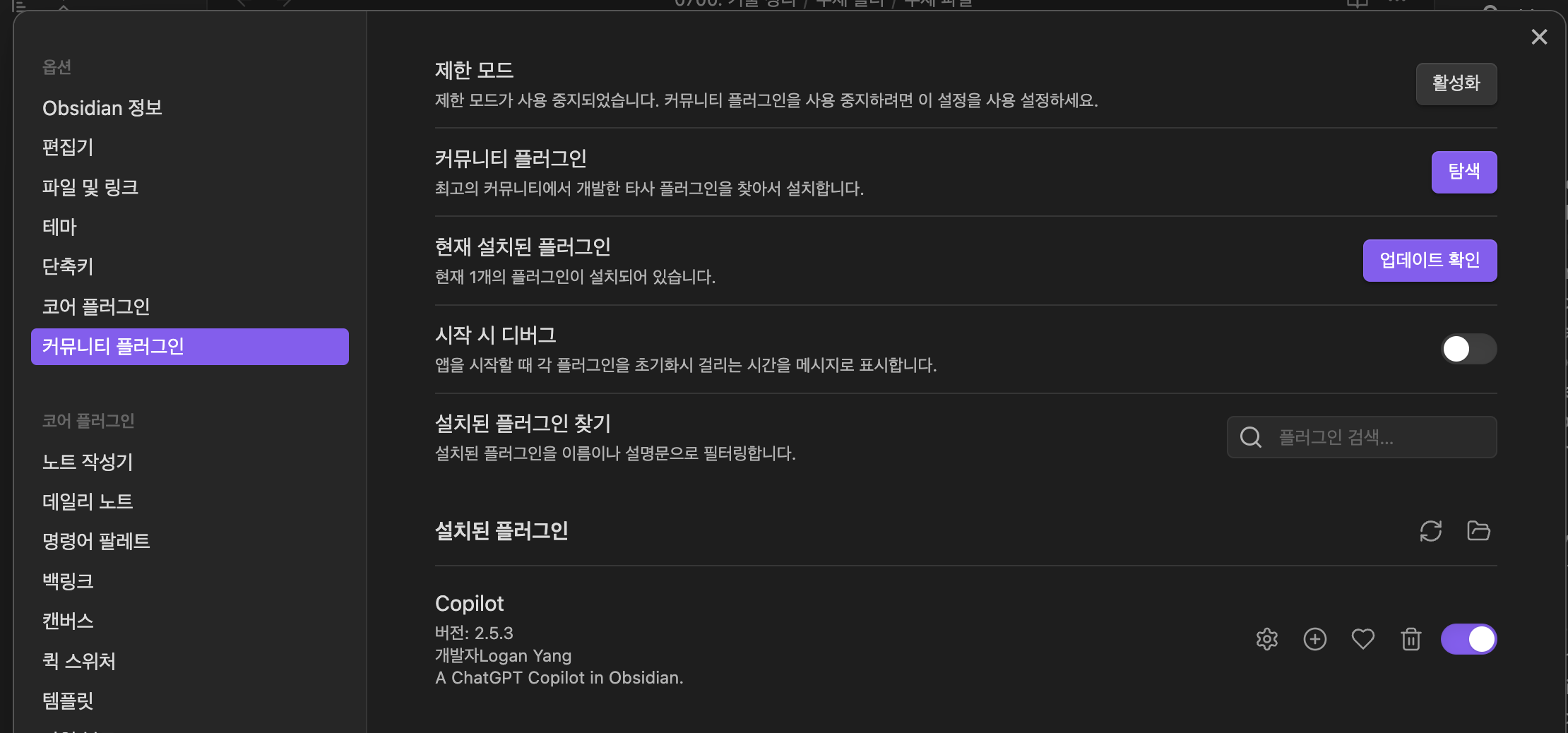

3.1. 커뮤니티 플러그인 활성화

커뮤니티 플러그인 사용을 활성화 화여 'Copilot'을 사용/활성화 한다.

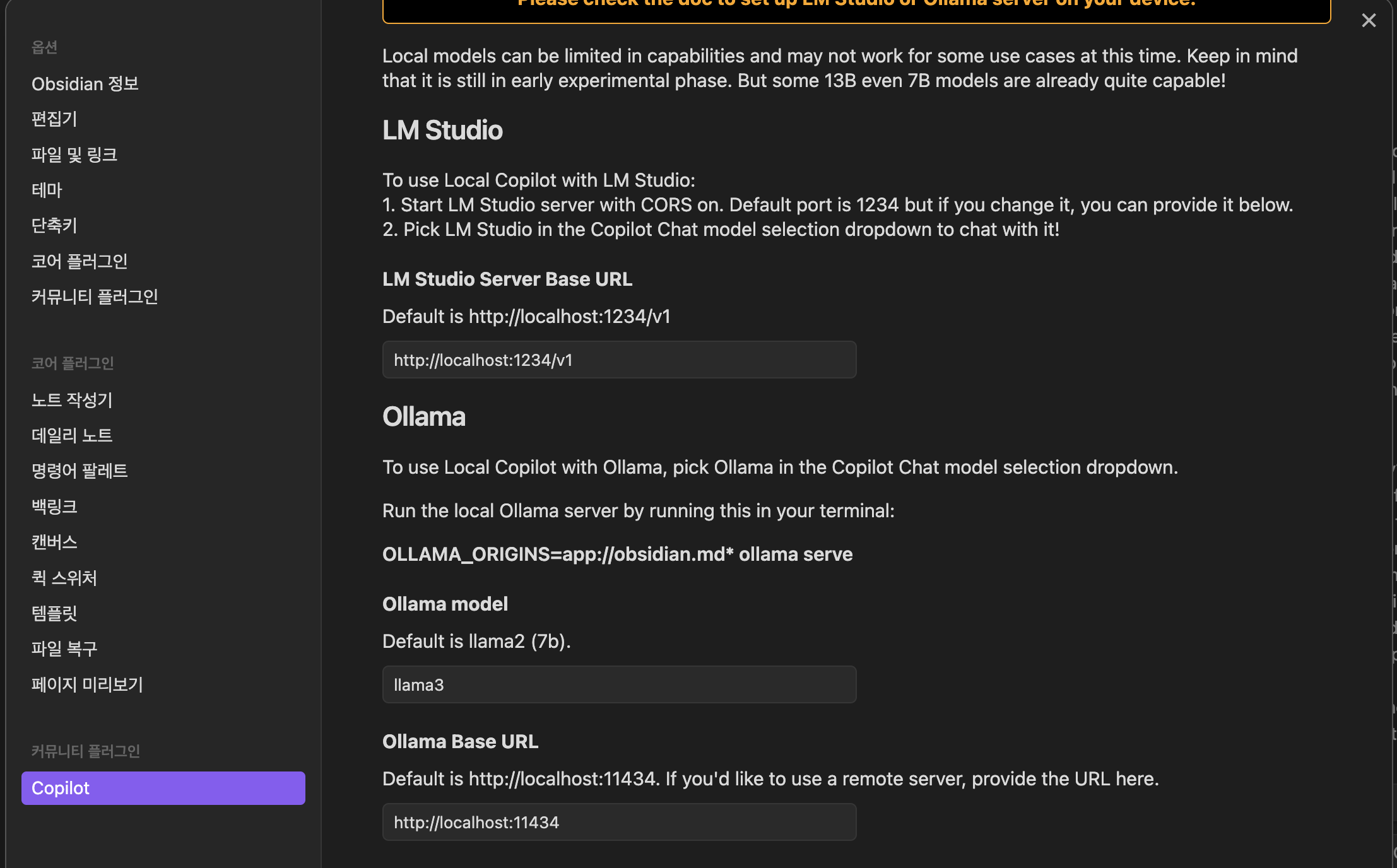

3.2. Copilot 플러그인 설정

- Obsidian 앱의 메뉴에서 'Preferences...' (Command + , ) 를 선택하여

메뉴 좌측 하단에 Copilot을 선택한다.

- 우측 화면에서 아래쪽으로 스크롤하여

Ollama가 보이면

Default is llama2(7b) 의 아래 내용에 위에서 받은 모델을 등록한다.

Ollama Base URL에 http://localhost:11434를 등록한다.

- 우측 화면에서 위쪽을 스크롤하여

Save and Reload가 보이면 클릭하여 저장과 모델을 사용하게 된다.

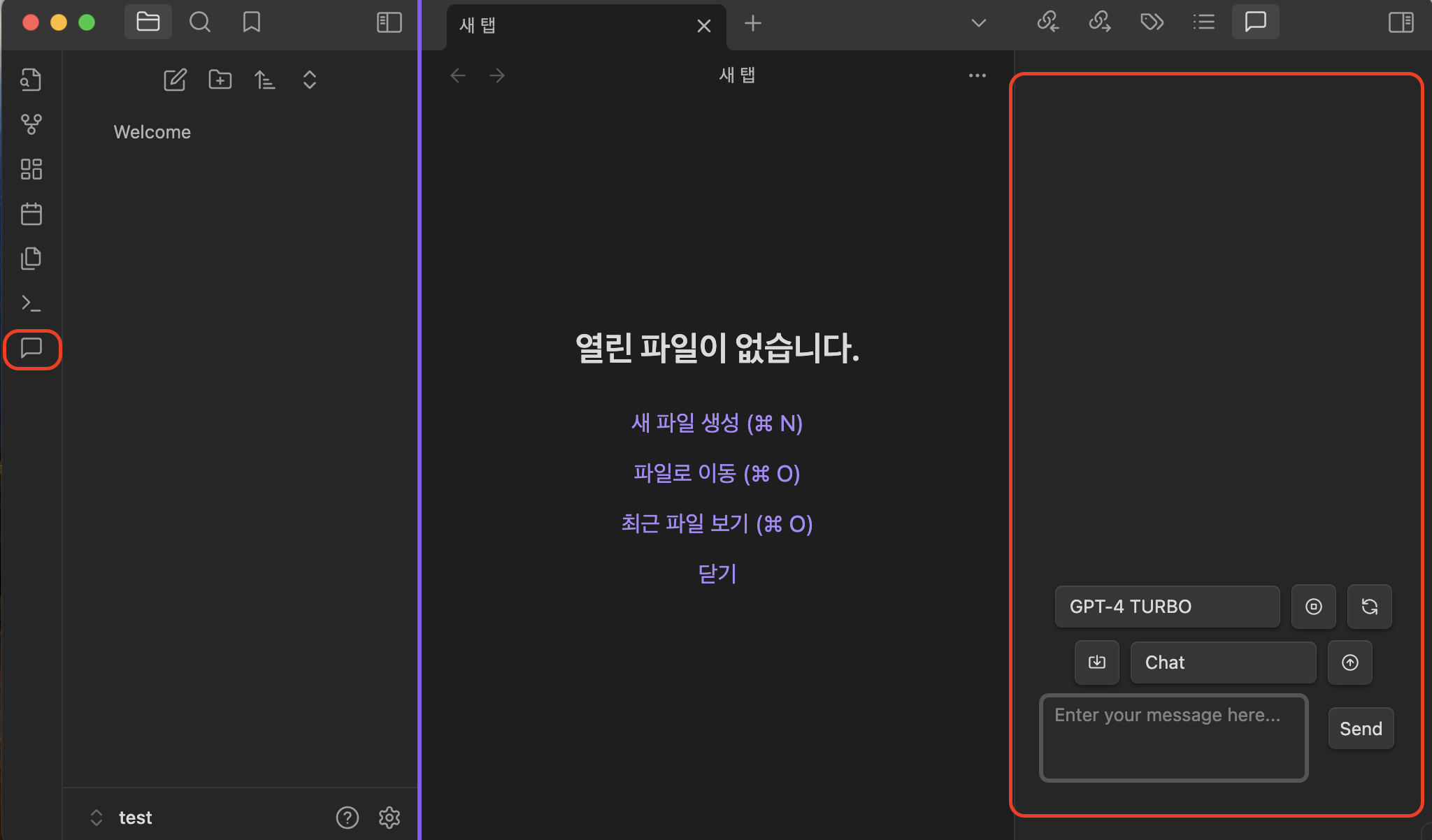

4. Obsidian에서 사용

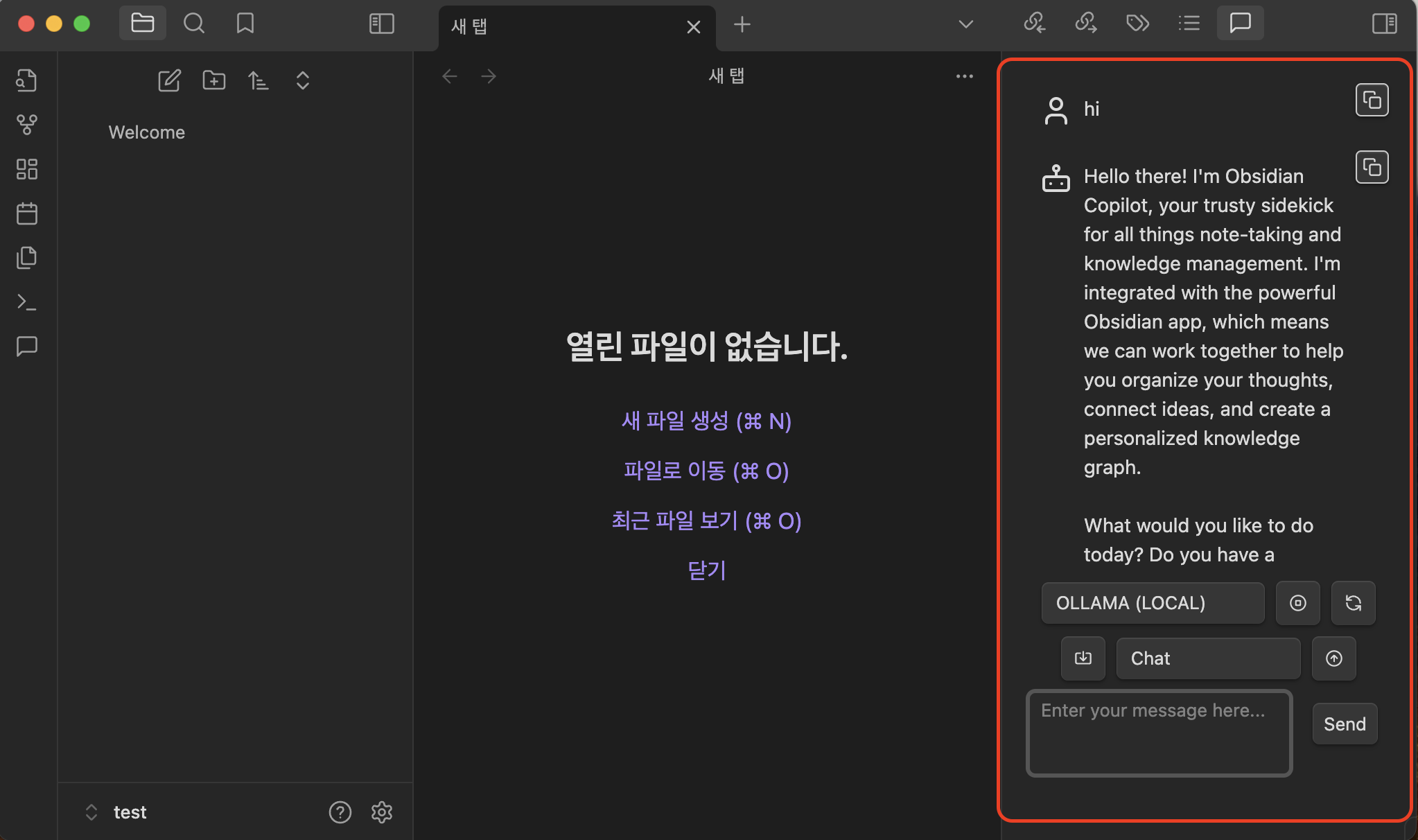

- 좌측 메뉴에서 Copilot Chat을 선택하면 우측에 Chat창이 활성화된다.

- Ollama에 모델로 선택 후 대화를 시도해 본다.

5. 참고

Ollama

Get up and running with large language models.

ollama.com

https://github.com/logancyang/obsidian-copilot/blob/master/local_copilot.md

obsidian-copilot/local_copilot.md at master · logancyang/obsidian-copilot

A ChatGPT Copilot in Obsidian. Contribute to logancyang/obsidian-copilot development by creating an account on GitHub.

github.com

.

' 장난감' 카테고리의 다른 글

| Whisper WebUI 로컬에 설치/실행 하기 (1) | 2024.07.26 |

|---|---|

| Windows 7 무선 AP사용하기 (0) | 2014.03.11 |

| Apache(httpd)와 Jenkins 설치 (0) | 2014.03.08 |

| Tomcat Cluster 설정 (0) | 2014.03.06 |

| tomcat manager-gui (0) | 2013.12.21 |